チャットAIのプライバシー保護レベルには差があり、企業利用では適切な選択が不可欠。会社の企画書、ChatGPTに丸投げしていませんか?

AI業界で最もプライバシー重視で知られていたClaude(Anthropic社)は、データポリシーを180度転換しました。「学習に使用しない」から「ユーザーの許可を得て使用」への大転換です。

AI開発コストが急激に増加する中、各社がユーザーデータ活用へと舵を切り始めています。私たちが何気なく入力している社内情報や相談内容は、どこまで保護されているのか。もはや「なんとなく大丈夫」では済まない状況だと言えるでしょう。

今回の記事では、ChatGPT、Claude、Gemini、MicrosoftCopilotの実際の保護レベルを比較しました。チャットAI4強のプライバシー保護レベルと、安心してAI協業を始めるための具体的な選択基準をお伝えします。

AIプライバシー保護が根本から変わる?

2025年8月は、AI業界の風向きが変わった時だと記憶されていくでしょう。これまで最もプライバシー保護に敏感だったAnthropic社が、チャットAIサービス「Claude」のユーザーデータ取り扱いを根本的に変更すると発表したからです。

従来のClaude利用についてAnthropic社は「ユーザーとの対話内容を学習に使用しない」を明確に打ち出していました。他社が学習使用を前提とする中で、このプライバシーに関する姿勢は差別化要因となっていたのです。しかし新ポリシーでは「ユーザーの許可を得て学習に利用する」方式に転換されました。

この変更により、データ保持期間も大幅に延長されています。拒否選択をした場合は30日間、同意した場合は5年間という設定です。つまり、何も設定しなければ5年間データが保持される可能性があるということです。

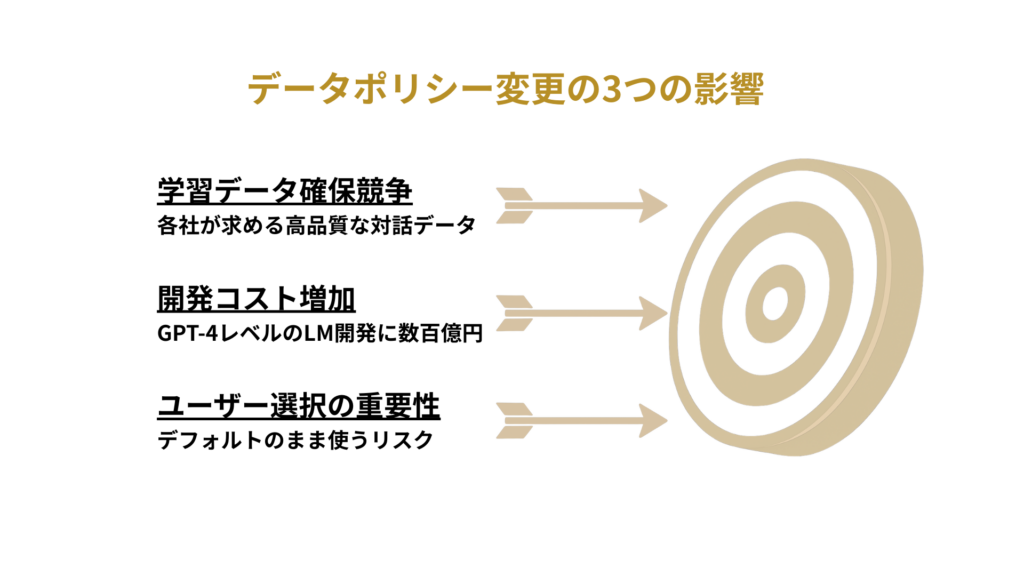

なぜAnthropic社はこうした転換を決断したのでしょうか。公式発表では「ユーザー体験の向上とモデル性能の改善」を理由としていますが、背景にあるのはAI開発競争の激化です。

Anthropic社は2024年に615億円の資金調達を実施し、企業価値は約9兆円に達しています。この巨額投資を回収するには、モデル性能の継続的向上が不可欠です。そのためには、ユーザーとの実際の対話データが最も価値の高い学習素材となるのです。

しかし、この状況はAnthropic社だけの課題ではありません。OpenAI、Google、Microsoftも同様に巨額の開発投資を続けており、データ活用の圧力は業界全体で高まっています。各社がより多くのユーザーデータを求める中で、それぞれ異なるリスクも抱えているのが現実です。

その典型例が、OpenAIで2023年3月20日に発生した公式の情報流出事故でした。ChatGPT Plusの一部ユーザーの個人情報が約9時間にわたって流出したのです。

この時、バグが原因で、ChatGPT Plusの一部ユーザーの個人情報が約9時間にわたって流出しました。アクティブユーザーの1.2%にあたる利用者の氏名、メールアドレス、支払い先住所、クレジットカード下4桁が他のユーザーに表示された事故です。

OpenAIは即座にサービスを停止しバグを修正して公式に謝罪したものの、技術的な問題による情報漏洩のリスクが白日の下に晒された格好となりました。AI協業を安全に進めるためには「なんとなく使う」といった段階は過ぎ、これからは各社の保護レベルを把握すべきなのかも知れません。

AIプライバシー保護は無料有料企業版でどう違う?

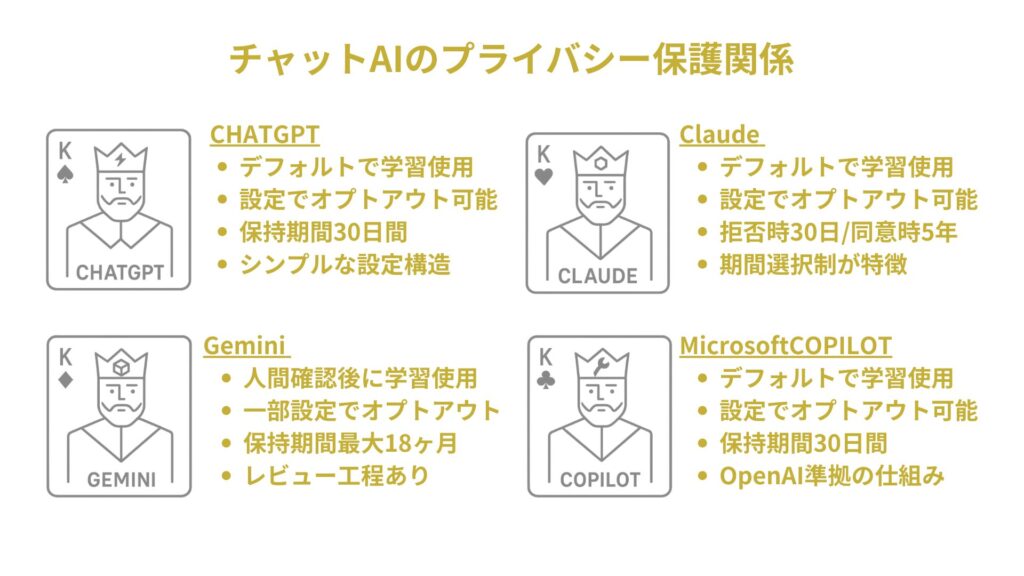

実際に各社はどの程度ユーザーデータを保護しているのでしょうか。公式ポリシーを詳しく調査した結果、サービスによって保護レベルに大きな差があることが判明しました。まず無料版の比較から見てみましょう。

最も広く使われているChatGPTは、デフォルトでユーザーとの対話を学習に使用します。設定画面でオプトアウト(学習拒否)選択が可能で、この設定を行えば学習には使用されません。しかし、履歴をオフにしていても、不正利用監視のために30日間はデータが保持されます。

Claudeは前章で説明した通り、現在ユーザーデータの学習使用をオプトアウトで選択するように変更されています。設定で拒否を選択しない限り、対話内容が学習に使用される可能性は否定できません。データ保持期間は拒否選択時で30日間、同意時で5年間と大きく異なります。

Google の無料版 Gemini Apps では、会話やフィードバックの一部が匿名化された状態でGoogleのレビュアーによって確認され、AI 改善に利用されることがあります。デフォルトで 18 ヶ月保存され、設定により 3 ヶ月や 36 ヶ月、無期限に変更でき、手動削除も可能です。ただしレビュー対象となったデータは最大 3 年間保存され、Gemini Apps Activity をオフにしても会話は安全対策のため72 時間保持されます。

Microsoft Copilotの無料版については、Bingベースの検索機能と組み合わせたサービスとなっています。基本的にはOpenAIのモデルを使用しているため、データの扱いはChatGPTに近い形となります。

重要なのは、個人有料プラン(Claude Pro、ChatGPT Plus等)でも、データ保護レベルは無料版とほぼ同じだということです。月額料金を払っているからといって、自動的にプライバシー保護が向上するわけではありません。

冒頭で説明したClaudeの方針転換についても、個人有料版であるProユーザーは今回のデータポリシー変更の対象となります。ChatGPT Plusでも、デフォルトでは学習データとして使用され、オプトアウト設定が必要です。つまり、個人有料版では「高速化」「高機能化」は得られても、「プライバシー強化」まで期待できないと言えるでしょう。

ただ、この事実は落胆すべきものではありません。むしろ「設定が9割」という明確な指針が見えてきます。無料版でも適切な設定を行えば、十分に安全なAI協業が可能だということです。

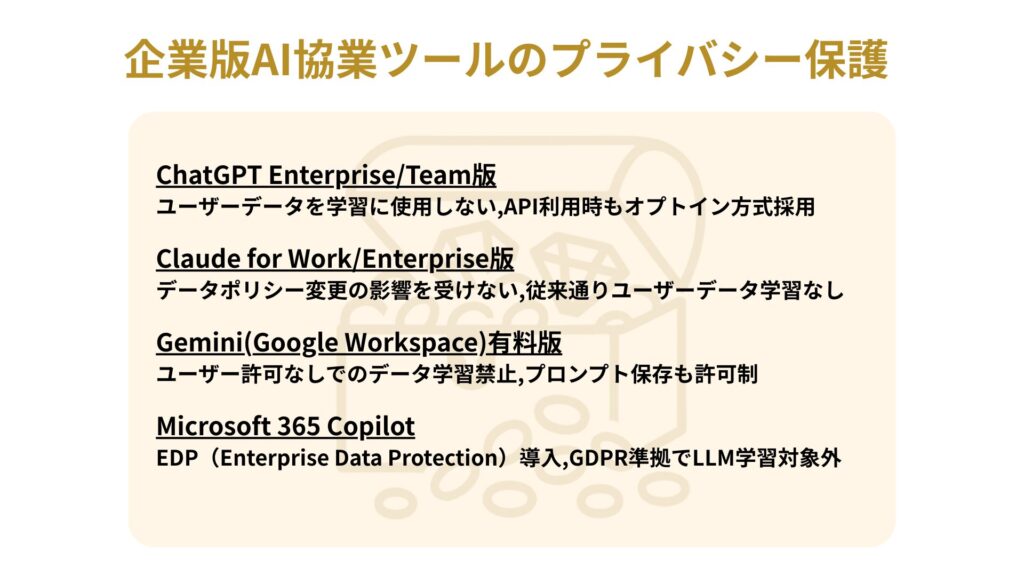

企業版・法人版になると、保護レベルは大幅に向上します。これは企業の法的要求とコンプライアンス基準に対応するためです。

ChatGPT EnterpriseやTeam版では、ユーザーデータが学習に使用されることはありません。API利用時も同様でユーザー側がオプトインを選択しない限り学習データとして扱われない仕組みです。

Claude for WorkやEnterprise版では、消費者向けプランとは異なる扱いとなります。これらの企業向けサービスでは、今回のデータポリシー変更の影響を受けません。従来通り、ユーザーデータが学習に使用されない仕様が維持されています。

Google Workspaceの有料版でも、ユーザーの許可なしにデータが学習に使用されることはありません。Workspaceデータは外部システムの学習に使用されず、プロンプトもユーザーの許可なしには保存されない設計になっています。

Microsoft 365 Copilotでは、EDP(Enterprise Data Protection)という包括的保護システムが導入されています。プロンプト、応答、Microsoft Graphデータはすべて基礎LLMの学習に使用されず、GDPR準拠の厳格な保護が提供されます。

企業版では各社ともデフォルトの状態でセキュリティ機能が大幅に強化されています。保存時・転送時の暗号化、アクセス制御、監査ログ機能など、一般的に企業が求める水準を保持していると言えるでしょう。

AIプライバシー基準はどうすれば安全?

「どのサービスが最も安全か?」という問いに対して、利用方法と予算によって大きく変わるという回答が見えてきます。

日常的な業務や学習には、無料版でも適切なオプトアウトを設定すれば十分活用できます。企画書の叩き台作成、メール文案の検討、プログラミングの学習などは、個人情報を除去した形で活用可能です。サブスク契約を検討するにしても企業版だとオーバースペックになる可能性は否めません。

機密性の高い業務では、Microsoft 365 CopilotやGoogle Workspaceのような、既存の業務環境に統合された企業向けサービスが現実的です。これらは従業員一人当たり月額数千円程で利用でき、コスト面でのハードルは比較的低いと言えるでしょう。

開発やクリエイティブ作業では、API利用という選択肢もあります。OpenAIやAnthropicのAPIは、ユーザー側でオプトインしない限り学習データとして使用されません。少し技術的な知識は必要ですが、コストパフォーマンスと安全性を両立できます。

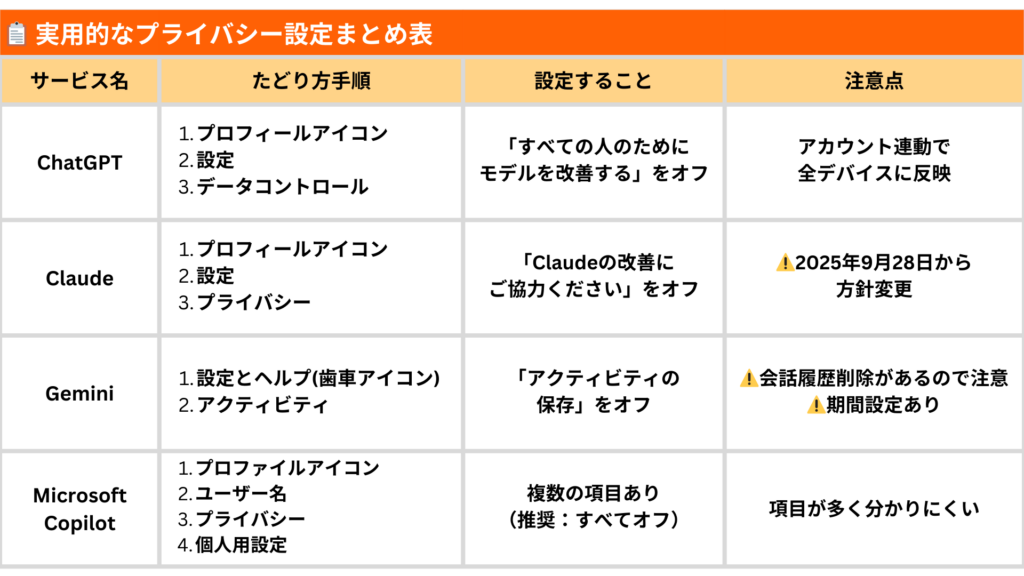

各サービスで重要なのは、サインアップ直後の設定確認です。チャットAIとの会話を積極的に学習させるつもりが無い場合は、各サービスの設定画面で調整しておきましょう。

設定後も定期的な見直しが大切です。AI業界は急速に変化しており、プライバシーポリシーも頻繁に更新されます。四半期に一度程度は、使用しているサービスの設定を確認する習慣をつけることをお勧めします。仮に企業版を採用する場合でも、念のためチェックしておいて損は無いでしょう。

企業でもフリーランスでもAI協業を始める際は、段階的なアプローチが効果的です。最初は非機密な作業から始めて、慣れてきたら徐々に重要度の高い業務にも適用する。この進め方なら、リスクを最小限に抑えながらAIの恩恵を最大化できます。

また、「ひとつのサービスに依存しないこと」も重要です。用途に応じて複数のサービスを使い分けることで、リスクを分散しつつ、それぞれの強みを活用できます。

AI協業時代を安心して迎えるために

調査を通じて見えてきたのは、AI業界全体の成熟化です。各社とも透明性を重視し、ユーザーに選択権を提供する方向に向かっています。Anthropicは今回、デフォルト設定こそ変更しましたが、明確なオプトアウト機能を提供しています。OpenAIも企業向けプランでの保護強化を進めており、Googleも学習使用の人間レビュー工程を公開しています。Microsoftは他社に先駆けてEDPという包括的保護システムを導入済みです。

これは「隠して使う」から「選択して使う」への業界全体のシフトを表しています。完璧ではありませんが、確実に前進していると言えるでしょう。

重要なのは、全てを秘密にすることではなく、何をどのレベルで共有するか自分で決められることです。日常会話レベルの内容なら学習に使用されても問題ないけれども、企業秘密は絶対に避けたいなど、使い分けができる環境が整いつつあります。

もっともその場合は設定を変更して、また元に戻すなど少々煩雑になり、オプトアウトに戻すことのうっかり失念も考えられるでしょう。ユーザーとの会話で学習した内容は、チャットAIにとって宝となり、巡り巡って一般ユーザーがその恩恵を得られる構図にはなりますが、組織やビジネスで使う場合は用心を重ねることがマストです。

現在チャットAIを事業に使用している場合は、仕様中のAIサービスの設定確認から始めるのが良いでしょう。各サービスでデータ使用に関する設定を確認し、方針に合わせることがAIによるプライバシー保護の第一歩です。

次に、用途別の使い分けルールを決めます。「個人情報を含む内容は入力しない」「企業の機密情報は専用サービスを使用」といった基準を明確にしておくことで、日常的に安全な利用ができます。定期的にレギュレーションを周知しなおすことや情報漏洩の実例を共有するのも効果的です。

そして段階的にAI活用の幅を広げていきます。最初は非機密な作業から始めて、慣れてきたら徐々に重要度の高い業務にも適用するといったステップ形式です。この進め方ならAIの恩恵を最大化でき、リスクは最小限に抑えられるかも知れません。

「完璧な安全性」を求めることではなく、「自分なりの安全基準」を持つ、或いは組織で共有することが大切です。正しく理解し、適切に選択すれば、私たちの生産性と創造性を大幅に向上させる素晴らしいパートナーとなるでしょう。

参考データ

OpenAI Help Center|Data Controls FAQ|

https://help.openai.com/en/articles/7039943-data-controls-faq

OpenAI Help Center|How your data is used to improve model performance|

https://help.openai.com/en/articles/7039943-how-your-data-is-used-to-improve-model-performance

OpenAI|March 20 ChatGPT outage: Here’s what happened|

https://openai.com/blog/march-20-chatgpt-outage

Microsoft Learn|Enterprise data protection in Microsoft 365 Copilot|

https://learn.microsoft.com/en-us/copilot/microsoft-365/enterprise-data-protection

Google Workspace Admin Help|Generative AI in Google Workspace Privacy Hub|

https://support.google.com/a/answer/15706919

Gemini Apps|Privacy Hub|

https://support.google.com/gemini/answer/13594961

Anthropic|Updates to Consumer Terms and Privacy Policy|

https://www.anthropic.com/news/updates-to-our-consumer-terms

Anthropic Privacy Center|How does Anthropic protect the personal data of Claude.ai users?|

https://privacy.anthropic.com/en/articles/10458704-how-does-anthropic-protect-the-personal-data-of-claude-ai-users

Anthropic Privacy Center|Terms of Service Updates|

https://privacy.anthropic.com/en/articles/9190861-terms-of-service-updates

Anthropic|Series E at $61.5B post-money valuation|

https://www.anthropic.com/news/anthropic-raises-series-e-at-usd61-5b-post-money-valuation

TechCrunch|Anthropic users face a new choice – opt out or share your chats for AI training|

https://techcrunch.com/2025/08/28/anthropic-users-face-a-new-choice-opt-out-or-share-your-data-for-ai-training/

NTTデータ|情報漏洩?企業における生成AI活用の落とし穴|

https://www.nttdata.com/jp/ja/trends/data-insight/2025/0703/

NEC|約2週間で生成AIの業務利用を実現 情報漏洩、信憑性、権利侵害リスクへの対応策は|

https://jpn.nec.com/LLM/Inhouse_case1.html

コメント